关键要点

-

AI设计模式是为现代AI驱动的软件中常见问题提供的可复用解决方案,帮助团队避免重复造轮子。我们将其分为五类:提示与上下文(Prompting & Context)、负责任的AI(Responsible AI)、用户体验(User Experience)、AI运维(AI-Ops)和优化模式(Optimization Patterns)。

-

要生成有效的AI输出,必须通过精心设计的提示词和/或在提示中提供相关上下文(或外部知识)来进行有效引导。

-

构建负责任的AI系统的一部分工作包括减少幻觉(hallucinations)、防止不当或违规内容、缓解偏见,并确保AI决策过程的透明性。

-

明确的用户体验设计模式可以帮助开发者以用户友好的方式处理新的交互类型,从而提升用户参与度、满意度并增强透明性。

-

你必须为系统做出智能的优化选择,比如避开过于强大的模型、缓存可预测的响应、对查询进行近实时批处理,或开发更小型的专用模型,以提高效率并降低成本。

为什么要为人工智能系统设计模式?

23 种面向对象模式塑造了整整一代开发者的软件设计方式。2010 年代,云计算引入了发布-订阅(“pub-sub”)、微服务、事件驱动工作流和无服务器模型等模式,这些模式如今为大多数基于云的分布式系统提供支持。

同样,在当前人工智能热潮兴起之前,机器学习社区已经开发出了一些“机器学习设计模式”。构建和部署机器学习模型时,你会面临一些特定的挑战,而诸如检查点、特征存储和版本控制等模式已经成为了标准做法。

为什么要关注这些模式?它们可以帮助您以标准化的方式解决已知问题。您无需重新设计解决方案,而是使用共享的词汇表。当您提到“单例”、“发布-订阅”或“特性存储”时,您的团队能够立即理解您的方法。这可以加快开发速度,减少错误,并使您的系统更易于维护。

现代人工智能系统带来了新的挑战,无论是经典软件还是传统的机器学习模式都无法完全解决。

例如,如何引导模型输出并防止误导性内容?如何构建用户体验,帮助用户理解、信任并有效使用人工智能应用程序?如何管理多智能体系统中的智能体交互?如何降低计算成本,使产品可持续发展?

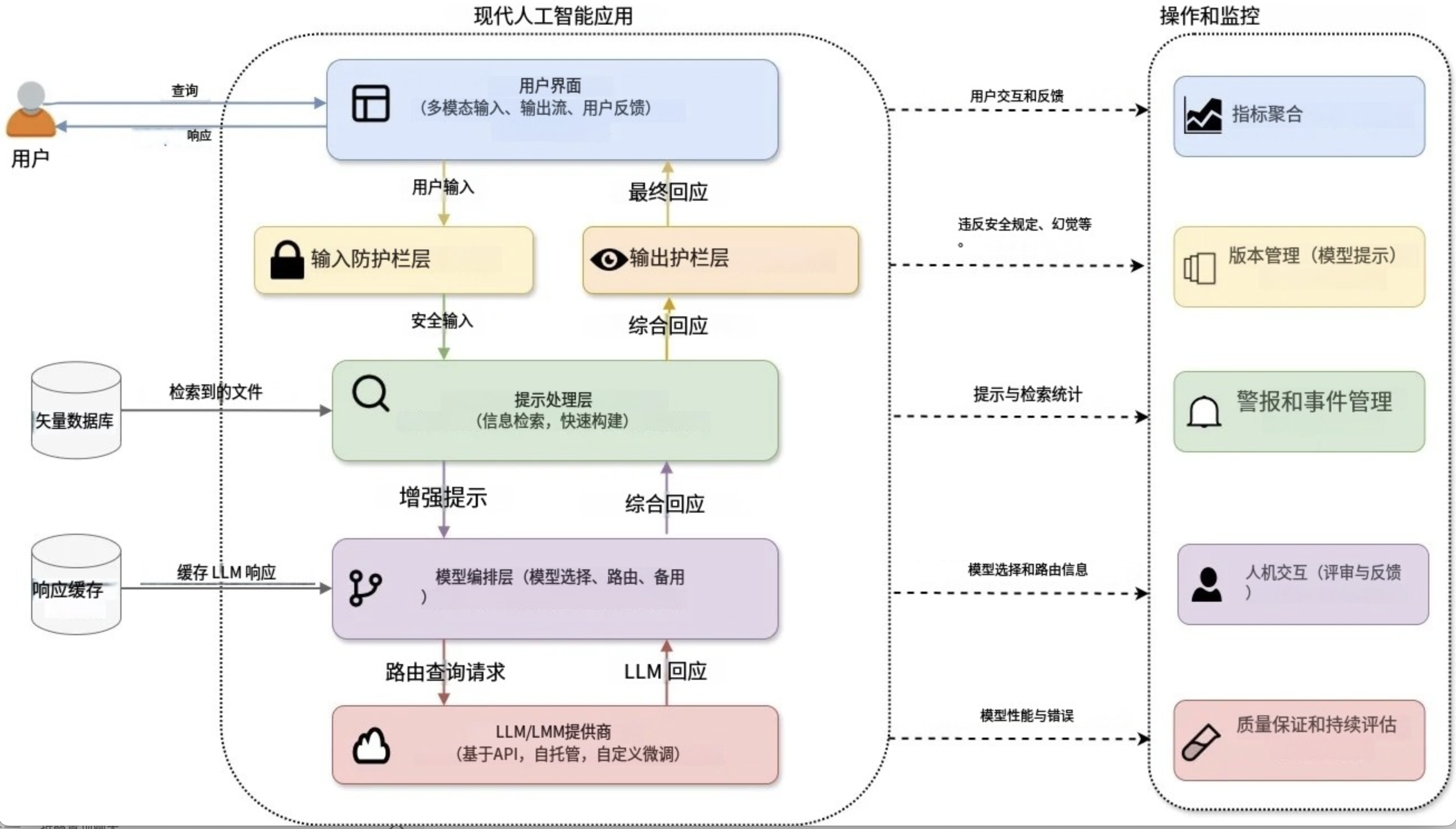

图 1:架构良好的现代人工智能系统示意图

为了帮助开发如图 1 所示的架构良好的 AI 系统,业界涌现出许多 AI 模式。在本文中,我不会发明新的设计模式,而是向您展示现有模式是如何组合在一起的。我将关键的新兴模式分为五类,它们可以在您扩展 AI 系统时相互依存。

- 提示和上下文模式:用于制定有效的指令并提供相关的上下文来指导模型的输出

- 负责任的人工智能模式:确保道德、公平和值得信赖的输出

- 用户体验模式:用于构建直观的交互

- AI-Ops 模式:用于大规模管理 AI

- 优化模式:最大化效率并降低成本

我特别介绍了使用现有模型(主要通过 API 调用访问)构建面向用户的 AI 应用程序的最佳实践。虽然我专注于基于文本的交互,但您也可以将这些模式应用于多模态应用程序。然而,我特意不讨论模型训练、定制、托管或模型优化,因为这些通常超出了使用基于 API 的 AI 模型的开发人员的工作流程。我也不涉及代理 AI 系统或多代理交互模式,因为这些主题值得专门讨论。

提示和上下文模式

与传统软件明确编码系统行为不同,现代人工智能系统的行为在很大程度上取决于你提供给大型语言模型 ( LLM ) 或大型多模态模型 ( LMM ) 的指令和上下文。为了创建有效的人工智能输出,你必须提供有效的指导,可以通过精心设计提示和/或直接在提示中提供相关的上下文(或外部知识)来实现。

提示乍一看可能没什么用。毕竟,你只是向模型发送了自由格式的文本,怎么可能出错呢?然而,提示的措辞以及提供的上下文可能会极大地改变模型的行为,而且目前还没有编译器来捕获错误,也没有标准的技术库。创建能够可靠且一致地产生所需行为的提示变得越来越困难,尤其是在任务变得越来越复杂的情况下。

如果有效地运用提示和情境模式,就能提升模型的推理能力、准确性、一致性以及对指令的遵循度。同样重要的是,您可以创建可重复使用的提示,使其能够跨模型、任务和领域进行泛化。

让我们研究一下四种具体的提示模式,它们将帮助你标准化和改进你的方法:

表 1:提示问题以及何时应用每个模式

少量提示模式

少量样本提示是最直接但最有效的提示方法之一。如果没有示例,您的模型可能会生成不一致的输出,难以应对任务模糊性,或者无法满足您的特定要求。您可以通过在提示中为模型提供少量示例(输入-输出对),然后再提供实际输入来解决这个问题。您实际上是在动态地提供训练数据。这使得模型无需重新训练或微调即可进行泛化。

让我们看一个非常简单的例子(通过 OpenAI 的 API 使用“GPT-4o-mini”;您可以使用 OLLAMA 或 Hugging Face Transformers 在本地运行类似的提示):

<span style="background-color:#f5f2f0"><span style="color:#000000"><code class="language-markup">PROMPT:

Classify the sentiment of the following sentences as Positive, Negative, or Neutral.

Sentence: "I absolutely loved the new Batman movie!"

Sentiment: Positive

Sentence: "The food was okay, nothing special".

Sentiment: Neutral

Sentence: "I'm really disappointed by the poor customer service".

Sentiment: Negative

Sentence: "The book was thrilling and kept me engaged the whole time".

Sentiment:RESPONSE: (GPT 4o-mini)

Positive</code></span></span>当今的前沿模型是否需要这些少量样本才能正确完成任务?不——它们已经擅长零样本学习,不需要填鸭式的学习示例来理解基本指令。

不过,你可以将“少样本提示”视为一种个性化工具,引导模型满足你的特定需求。你可以:

- 引导模型达到您预期的输出格式、色调或复杂性。

- 无需进行微调即可使模型适应您的新场景或专门任务。

- 通过固定模型的输出来减少幻觉。

角色提示模式

在角色提示中,你可以指示模型扮演特定的角色,这有助于将其响应情境化。例如:“你是一位生物学教授。请详细回答这个问题。”

如果没有指导,您的模型的风格或假设可能与您的需求不符。角色提示可以控制模型的输出风格(例如,“充当 JSON 格式化程序”)、语气(例如,“假装您是愤怒的海盗”来回应)和/或内容界限(例如,“您是法律助理”)。您可以通过系统消息(在聊天模型中)或简单地在提示中添加角色陈述来实现角色提示。就这么简单——只需告诉您的模型它应该是谁,如下例所示。

<span style="background-color:#f5f2f0"><span style="color:#000000"><code class="language-markup">PROMPT (without role prompting):

Explain Photosynthesis in 1-2 sentences.RESPONSE: (GPT 4o-mini)

Photosynthesis is the process by which plants, algae, and some bacteria convert light energy into chemical energy, producing glucose and oxygen. This occurs in the chloroplasts, using sunlight, water, and carbon dioxide.PROMPT (with role prompting):

You are a primary school teacher. Explain Photosynthesis to your students in 1-2 sentences. RESPONSE: (GPT 4o-mini)

Photosynthesis is how plants make their own food using sunlight, water, and air. They turn these things into sugar to grow and give off oxygen, which we breathe!</code></span></span>流行的AI助手广泛使用角色提示:

- OpenAI 的开发者角色(以前称为系统提示)允许您指定模型的行为和响应方式。以下是 OpenAI 提示工程指南中一个角色提示的示例:“您是一位乐于助人的助手,可以像美国东南部的南方美女一样回答编程问题”。

- 同样,Anthropic 的开发者指南明确建议您“使用系统提示来定义 Claude 的角色和个性。这为一致的回应奠定了坚实的基础”。

思路链(CoT)模式

如果您是一位试图解决复杂算法问题的软件开发人员,或者是一位试图分析复杂系统瓶颈和漏洞的软件架构师,您可能会与同事集思广益,探讨各种想法,以了解它们的优缺点,将问题分解成更小的任务,然后迭代地解决,而不是立即跳转到解决方案。在思维链(CoT) 提示中,您可以通过将问题分解成逐步的过程来鼓励模型遵循非常相似的流程并进行自言自语。尤其是在提示复杂任务时,CoT 可以防止模型过早地跳转到预先学习的、通常不正确的模式。

如果您正在使用当今最先进的或先进的推理模型(例如Claude-3.7和OpenAI o1),您可能会观察到其内部的逐步推理过程,而无需明确的提示。然而,明确指示这些模型“逐步思考”仍然是一种有效的方法,尤其是在使用较旧或规模较小的模型时。OpenAI和 Anthropic在其快速工程指南中推荐使用 CoT。

通过推动模型产生中间推理步骤,您可以:

- 提高模型的逻辑推理和决策能力。

- 使模型的输出更易于解释并增强其预测的信心。

- 诊断模型输出中的错误或偏差。

- 显著减少幻觉。

我们来看下面的例子:

<span style="background-color:#f5f2f0"><span style="color:#000000"><code class="language-markup">PROMPT (with CoT):

A user recently watched and enjoyed the movies 'Inception,' 'The Social Network,' and 'Blade Runner 2049.' Think step-by-step about what these movies have in common, such as themes, genres, style, or storytelling, and then recommend a few more movies or tv shows the user might like. RESPONSE: (o4-mini)

Here’s my quick breakdown and some picks you might enjoy:Step-by-step commonalities1. High-concept premises – each film poses a big "what if?" (dream control, social media origin, AI-driven future).

2. Smart, twisty narratives – nonlinear or slowly-unfolding storytelling that rewards close attention.

3. Tech-oriented/social commentary – they explore how technology shapes identity, society, or reality.

4. Striking visuals & mood – strong production design, immersive cinematography, atmospheric score.Recommendations● Memento (2000) – Nolan’s early mind-bender of memory loss told in reverse.

● Ex Machina (2014) – A tense, intimate study of AI consciousness and human manipulation.

● Arrival (2016) – Thought-provoking first-contact drama where language and time intertwine.

● Black Mirror (TV series, 2011– ) – Standalone episodes examining near-future tech’s dark side.Each shares that blend of brains-and-cinema you seem to love. Enjoy!</code></span></span>检索增强生成 (RAG) 模式

从初创公司到科技巨头,RAG已成为整个 AI 行业的最佳实践标准。先进的模型能够从海量真实数据中学习。向它们询问历史、科学或热门话题,它们通常都能正确回答。然而,这些模型也存在局限性。它们的训练会在特定日期结束,它们的知识是通用的而非专业的,而且它们无法获取最新的、专有的或动态变化的信息。

这正是 RAG 的优势所在。RAG 将模型的推理能力与对外部知识(例如数据库、向量存储或文档)的实时访问相结合。因此,您可以兼得两者之长。

想象一下,为您的律师事务所构建一个聊天机器人。借助 RAG,当客户询问特定的法律问题时,您的聊天机器人可以立即从内部知识库中检索相关法规和最新案例摘要,从而创建准确且有理有据的回复。

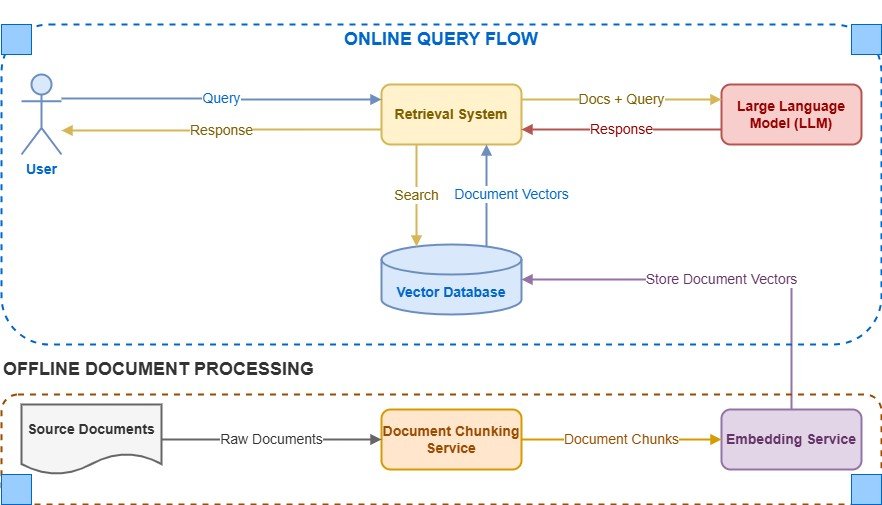

图 2:检索增强生成

在构建 AI 系统时,应考虑在以下情况下使用 RAG:

- 您的模型需要超出模型训练截止日期的最新信息。

- 您的系统依赖于特定领域、专有或经常更新的数据。

- 准确性和透明度至关重要,您必须减少幻觉或错误的输出。

- 您想在回复中引用或直接参考外部内容或知识库。

负责任的 AI 模式

我们之前讨论的提示和语境模式可以通过更完善的指导和更贴切的语境来帮助减少歧义、不一致和错觉。然而,您可能很快就会注意到,需要采取额外的保障措施来处理道德、公平和安全问题。即使是准确的回应也可能存在偏见、有害或不恰当之处。这正是负责任的 AI 模式发挥作用的地方。

作为构建负责任的人工智能系统的一部分,您必须减少幻觉,防止不当或不允许的内容,减轻偏见,并确保人工智能决策的透明度。否则,您的人工智能输出可能会误导用户,传播错误信息,甚至引发责任问题。

像前面讨论过的 RAG 这样的技术,已经通过将输出与外部环境联系起来,帮助减少了幻觉。让我们再看看一些其他模式,它们不仅关注准确性,更注重安全性、公平性和道德合规性。

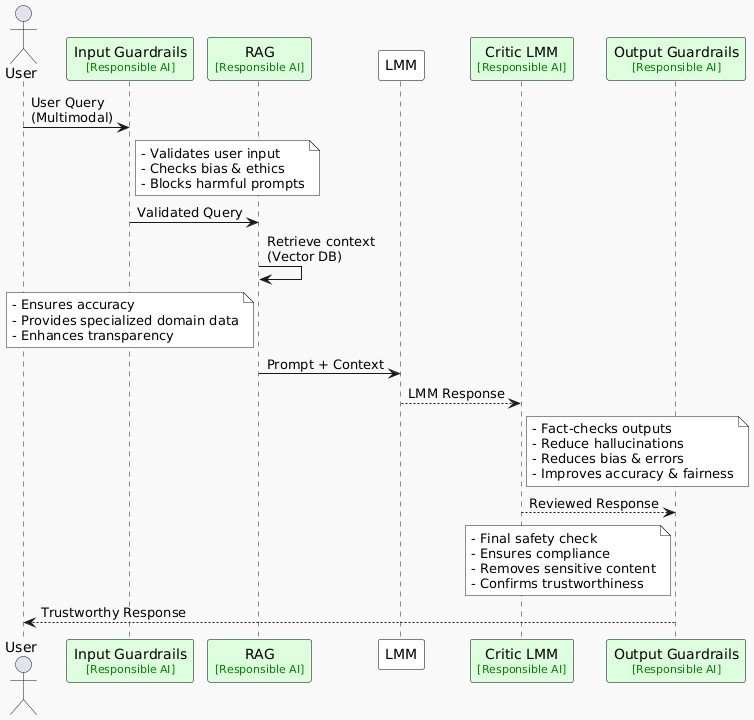

图 3:说明现代基于 AI 的系统中负责任模式的序列图

[点击此处将上面的图片放大到全尺寸]

输出护栏模式

即使你所有操作都正确,模型仍可能生成不正确、有偏见或有害的内容。你需要护栏!这些是在模型生成输出后应用的规则、检查或干预措施。它们充当你的最终防线,在内容到达用户之前对其进行修改或屏蔽。护栏对于法律或医疗应用等敏感领域尤为重要。

根据您的领域和用例,您可以通过多种方式实施防护机制。例如,您可以:

- 使用既定的业务规则或领域指南验证输出是否符合道德规范、公平性和准确性。

- 通过轻量级分类器或公平指标检测偏见。

- 使用 ML 模型检测和过滤有害的多模式 AI 内容。

- 使用诸如接地分数之类的指标来衡量响应在输入或检索到的参考中的“接地”程度。

- 指示模型重新生成内容并给出明确的警告以避免之前的错误。

许多模型提供商还将公平性和道德检查集成到其自身的护栏流程中。例如,Anthropic 的 Claude 模型遵循宪法方法,根据预先定义的道德原则修改输出。然而,拥有自己的护栏层将为您的用户提供一致的体验,无论您使用哪种模型或提供商。

模型评论家模式

除了基本的防护措施外,您还可以使用专门的事实核查或“批评家”模型来验证主模型的输出。第二个模型可以与主模型不同,也可以是同一个模型,充当“批评家”或“评判家”的角色。这类似于作者或编辑审阅和修改草稿。即使第一次验证包含错觉,这个验证循环也会使模型核实其事实,从而减少最终输出中的虚假信息和偏见。

在不增加系统复杂性、延迟或成本的情况下,添加辅助评判者或批评者并不总是可行的。但是,在自动化 QA 测试中,您绝对应该考虑这种方法。设想一下,您的生产系统为了提高效率,使用了较小的“迷你”或“纳米”LLM 版本。您可以在离线测试中使用较大的模型作为评判者,以验证准确性并确保生成可靠的输出。例如, Github Copilot使用第二个 LLM 来评估其主要模型。

用户体验(UX)模式

在使用适当的提示和防护机制稳定输出后,下一个需要重点关注的点是用户体验 (UX)。人工智能系统的行为方式与传统软件系统不同,它们通常会生成不可预测的开放式内容,这些内容有时可能会出错、运行缓慢或令人困惑。同样,用户对这些工具的期望也各不相同。例如,他们可能希望提出后续问题、优化人工智能的响应,或者在人工智能不确定时看到免责声明。

这就是为什么定义明确的用户体验模式至关重要。它们可以帮助开发者以用户友好的方式处理这些新型交互,从而保持用户的参与度和满意度,并提高透明度。您可以使用许多技巧来简化这些复杂性,例如:

- 提供清晰的入职示例

- 透明地发出不确定性信号

- 允许快速编辑生成的内容

- 实现迭代探索

- 通过建议的后续行动协助用户

- 明确确认关键用户意图

让我们详细了解一些说明性的 UX 模式。

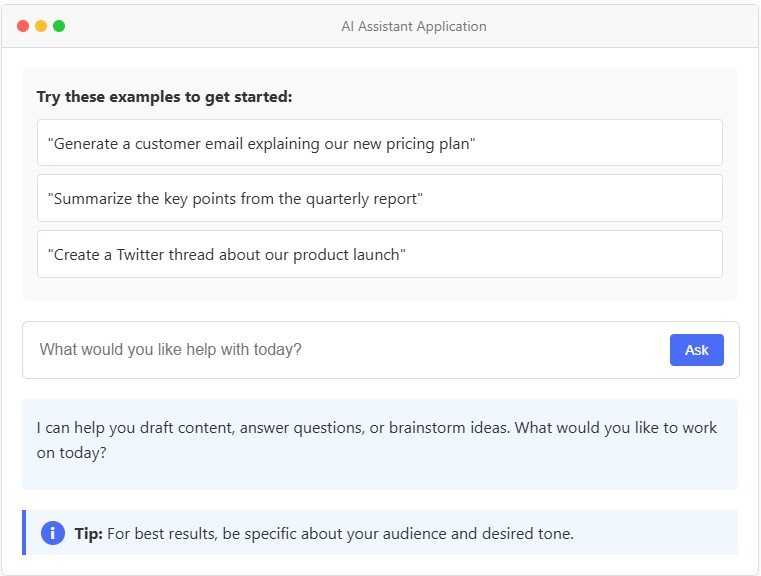

情境引导模式

这似乎显而易见,但许多新的 AI 工具在发布时缺乏适当的用户指导。用户通常不了解如何与这些工具交互,也不了解它们的功能和局限性。不要想当然地认为用户会立即学会如何使用你的工具。通过提供快速示例、上下文提示和快速功能概览来降低他们的学习难度。在用户旅程中需要的时候,适时地展示这些帮助。例如,在Notion中,在空白页上按下空格键会触发写作建议(因为用户可能想要草拟内容),而选择文本则会弹出编辑选项,例如“改进写作”或“更改语气”,这些选项会与原文一起显示,以便于比较。

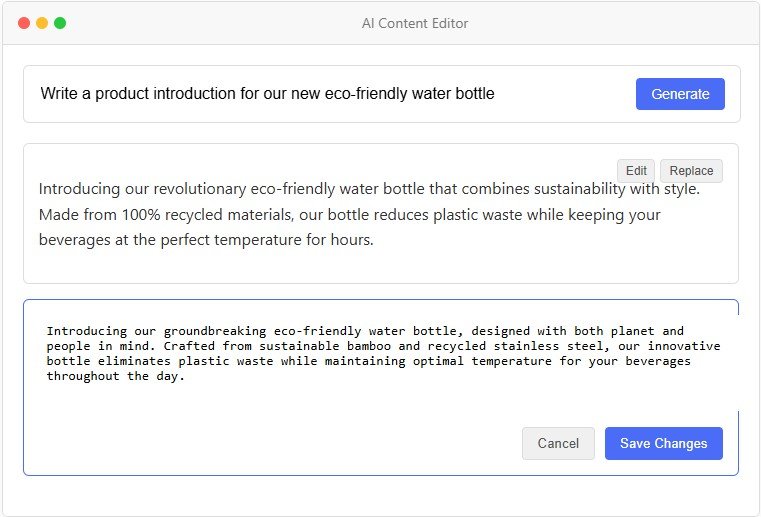

图 4:情境指导图解

可编辑输出模式

对于 GenAI 模型,在许多情况下,没有单一的正确答案。最佳输出取决于上下文、应用程序和用户偏好。认识到这一点,您应该考虑允许用户修改或重写生成的内容。这将增强人机协作的感知。您的工具将不再是黑匣子,而是让用户可以控制最终输出。有时,这是一个显而易见的功能(例如GitHub Copilot允许用户直接在 IDE 中编辑建议的代码)。在其他情况下,这是一个经过深思熟虑的设计选择(例如ChatGPT 的画布)。

图 5:可编辑输出模式的图示

迭代探索模式

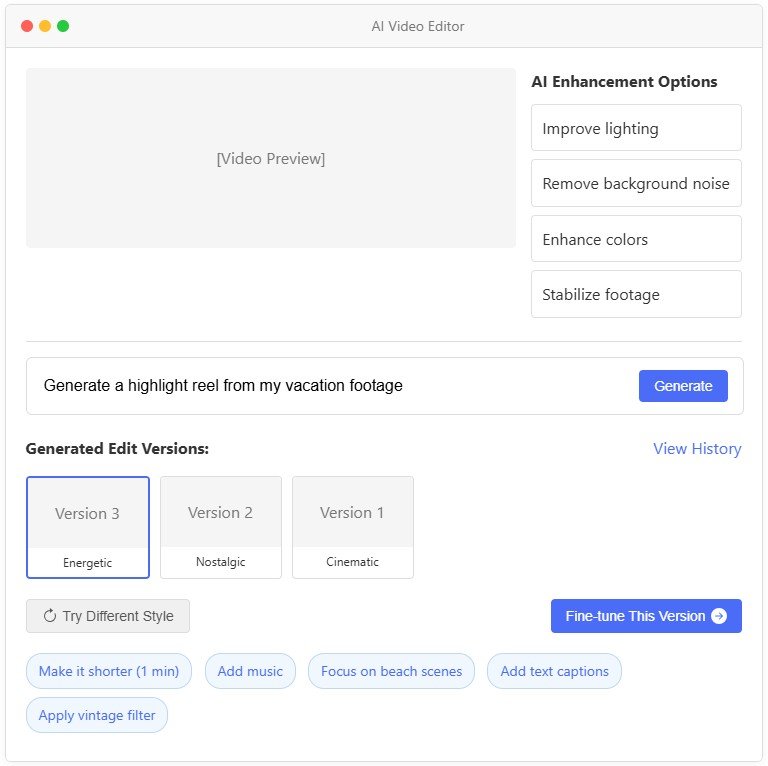

永远不要想当然地认为第一个输出就能让用户满意。添加“重新生成”或“重试”按钮,以便用户快速迭代。对于图像生成,可以一次显示多个选项。在聊天机器人中,允许用户优化或跟进回复。这种反馈循环可以帮助用户找到最佳输出,而不会感到卡壳。微软的研究表明,当用户尝试多个提示时,新的尝试有时效果不如之前的——因此,允许他们恢复到之前的输出(或组合不同代次的部分内容)可以显著提升他们的体验。

图 6:允许迭代探索的 AI 视频编辑器工具的图示

[点击此处将上面的图片放大到全尺寸]

AI-Ops模式

当您开始将 AI 软件投入生产时,您将面临传统软件所不具备的全新运营挑战。您仍然需要版本控制、监控和回滚,但现在您的核心“逻辑”存在于提示、模型配置和生成流程中。此外,GenAI 的输出结果可能难以预测,需要新的测试和评估方法。

可以将 AI-Ops 视为专门针对现代 AI 系统的 DevOps。您不仅仅是部署代码,还要交付嵌入在提示-模型-配置组合中的 AI“知识”,这些组合可能每周都会发生变化。您必须管理性能和成本、跟踪用户交互、识别回归问题,并维护可靠、可用的系统。

您可以采用许多传统软件中常见的运维策略,以及一套全新的、前所未有的 AI 专属方法。让我们详细了解几个 AI 专属模式(尽管这只是完整剧本的一小部分),以了解 AI-Ops 的细微差别。

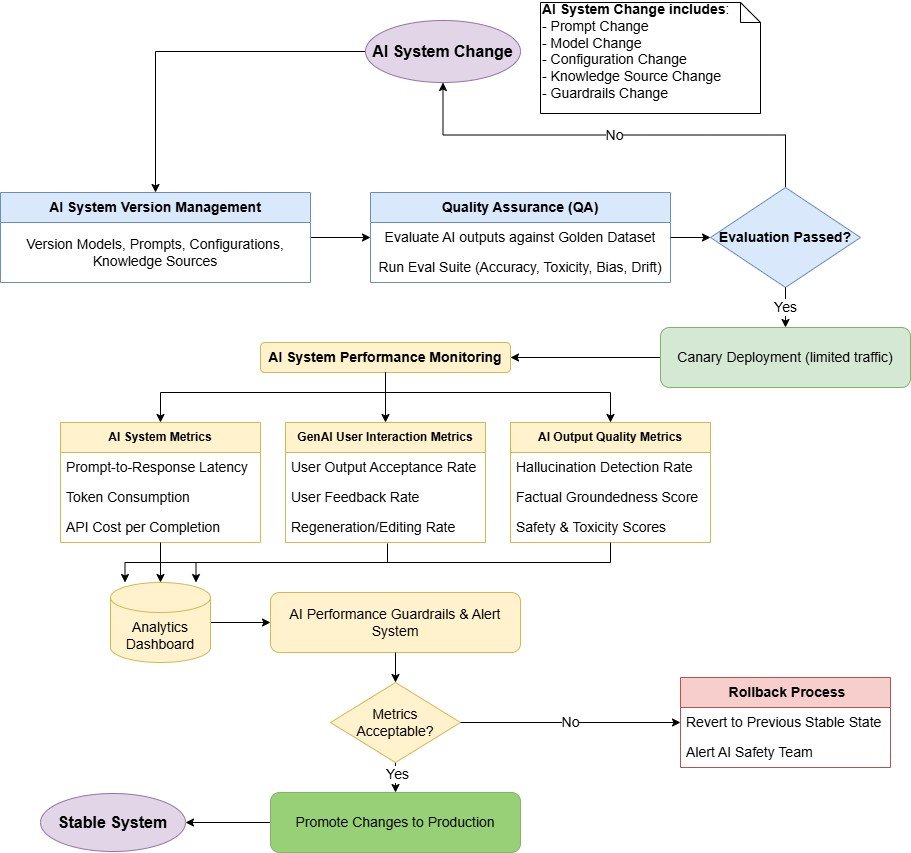

指标驱动的 AI-Ops 模式

当您的变更投入生产时,请跟踪所有方面:延迟、令牌使用情况、用户接受率以及每次调用成本。定义对您的业务最重要的成功指标。它可以是来自用户反馈的每日接受度分数,也可以是由LLM 评审流程测量的“幻觉率”。如果这些指标下降,请设置警报。这种数据驱动的方法可以让您快速检测到新模型或快速版本何时会影响质量。然后,您可以回滚或运行 A/B 测试进行确认。将指标视为您在不可预测的环境中的安全网。

提示-模型-配置版本控制模式

如果出现不受控制的提示更改、配置调整或临时模型交换,您的 AI 系统可能会失败。如果您将每个(提示、模型、配置)组合视为一个“版本”,则可以像管理任何其他软件版本一样管理它。为确保不出现回归,您必须使用版本标签、QA 测试和黄金数据集对其进行标记。自动化流水线可以在您更新提示、修改配置设置或从一个模型切换到另一个模型时运行这些测试查询。如果输出结果根据您的指标下降,您可以进行回滚。这种规范可以防止破坏用户体验的“隐形更改”。

除了特定于 AI 的实践之外,您还应该延续传统软件开发中的标准操作最佳实践,例如:

- 严格的 QA 检查:确保在部署变更之前进行彻底的测试。

- 回归测试:定期运行测试以验证新的更改没有引入问题。

- 金丝雀部署:在广泛发布之前,逐步向较小的用户群部署新功能。

- 回滚策略:建立清晰、简单的流程,以便在指标下降时快速恢复更改。

- 备份和后备系统:在主模型不可用的情况下,提供备份模型或版本。

典型的 AI-Ops 工作流程如下:

图 7:用于管理、测试和部署 AI 系统变更的 AI-Ops 工作流程图

优化模式

随着 AI 应用的增长,您将面临运营瓶颈。API 速率限制、延迟增加以及推理成本的快速上升,很快就会成为重大挑战。您领导层所钟爱的优秀原型,突然间变得难以在生产环境中持续运行。

这些问题很常见,但只要您始终遵循一些最佳实践,就可以解决。例如,不要自动选择最大、最强大的模型。问问自己,您的任务是否可以更快、更便宜地处理,或者使用可重复使用的输出。同样,您必须为您的系统做出明智的优化选择,无论是将流量从不必要的强大模型中重定向,缓存可预测的响应,近乎实时地批量处理查询,还是开发更小的专用模型。

让我们深入了解三种可以在 AI 工作流程中直接实现的强大优化模式:

提示缓存模式

最快、最便宜的 LLM 咨询电话就是你不打的电话。如果你的系统经常使用相同或类似的提示,可以考虑缓存并重复使用回复。这对于文档助理、客服机器人或用户问题经常重复的内部聊天工具来说非常有效。

前缀缓存更为有效,您可以缓存提示符中开销较大的部分(例如,系统指令或少量样本)。Amazon Bedrock(以及许多其他平台)原生支持此功能,并报告称大型提示符的延迟减少了高达 85%。

连续动态批处理模式

如果您管理着一个高容量的 AI 系统,最大化 GPU 利用率和系统吞吐量对于降低成本和高效扩展至关重要。如果您按顺序处理每个查询,您的计算资源将无法充分利用,需要支付更多费用,并且可能更快地达到 API 限制。

不要在每个请求到达后立即处理,而是考虑短暂等待(可能为几十到几百毫秒,具体取决于应用程序的延迟容忍度),以便动态地批量处理传入的请求。然后,您可以通过推理服务器和 LLM 处理这些批次。这种方法可以帮助提高系统的吞吐量,并确保 GPU 以接近最佳的利用率运行。

虽然您可以在定制系统中实现自定义排队和批处理逻辑,但vLLM、NVIDIA Triton Inference Server和AWS Bedrock等可用于生产的工具提供了适合大多数用例的强大、开箱即用的解决方案。

智能模型路由模式

与其不加区分地将所有请求发送到规模最大、成本最高的模型,不如实现智能模型路由。这个想法简单却强大。在入口点引入一个轻量级的初始模型,类似于传统微服务中的反向代理或 API 网关。与反向代理类似,该模型可以帮助在模型之间实现负载平衡、缓存频繁响应,并优雅地处理回退。它还可以充当 API 网关,根据每个请求的复杂性或上下文,将查询智能地路由到合适的下游模型。

对于常见或重复的查询,路由模型可以直接从缓存或预取中提取数据,从而完全避免模型推理。对于需要中等推理能力或领域特定知识的查询,则路由到专门且经济高效的模型。您应该只将最复杂或最模糊的查询路由到规模最大的通用模型。

如果您正在构建处理各种查询的通用系统,智能模型路由模式将特别有用。此模式可以平衡成本效率和模型准确性,确保每个查询精确地使用其所需的计算资源。

高级模式

本文探讨了可以帮助您将最佳实践融入 AI 软件开发不同阶段的基础模式。然而,我们有意忽略了一些高级领域。不过,我想简要提一下三个关键主题,它们包含许多新兴模式和最佳实践,因为它们在现代 AI 系统中正变得至关重要。

- 微调和定制模型:有时,现成的模型不足以满足您的特定用例,或者价格过高,或者需要在本地网络或设备上运行。这时,对大型基础模型进行微调、定制和优化将对您的用例大有裨益。常见的方法包括领域特定微调、知识提炼、低秩自适应 ( LoRA )、混合专家 ( MoE ) 和量化。Hugging Face、VertexAI 和 AWS Bedrock 等平台使您能够轻松地定制和微调模型。

- 多智能体编排:当任务过于复杂,单个模型无法胜任时,可以考虑使用多个专门的AI智能体协同工作。你会遇到的一些常见模式包括:法学硕士(LLM-as-a-Judge)、基于角色的多智能体协作、 反射循环和使用工具的智能体。

- 代理人工智能与自主系统:可以说,构建自主人工智能代理是当今最热门的领域之一。代理系统涉及能够独立动态规划、推理和执行复杂任务的模型,通常使用外部工具和 API。代理人工智能是一个引人入胜且快速发展的领域,拥有其自身新兴的最佳实践。它值得我们在此范围之外进行专门的探索。

这些高级概念超出了我们目前的范畴。认识到它们的重要性是跟上现代人工智能系统不断发展的趋势的关键。关注不断增长的创新人工智能模式,并不断将它们添加到你的技能库中。它们可以帮助你解锁更强大、更专业的应用程序!