大家好,我是吾鳴。

今天要给大家分享的内容是关于DeepSeek模型如何进行本地部署与应用构建。它主要是由智灵动力陈军老师出版的一份教程,教程内容非常详细的介绍了DeepSeek本地化部署的必要性,如果有本地部署DeepSeek的朋友可以收藏作为你的本地化部署的指导手册。文末有完整版下载地址,内附上视频。

这份教程的内容包括DeepSeek简单介绍与使用、DeepSeek本地部署、本地知识库搭建和实际应用场景。为何需要本地部署DeepSeek?要解决什么问题才选择本地部署?本地部署DeepSeek需要的硬件配置?等问题,读完都可以得到你想要的答案。下面我会给出每一部分的内容简介,以及给大家展示一些精彩的内容。

内容摘要

- DeepSeek简单介绍与使用

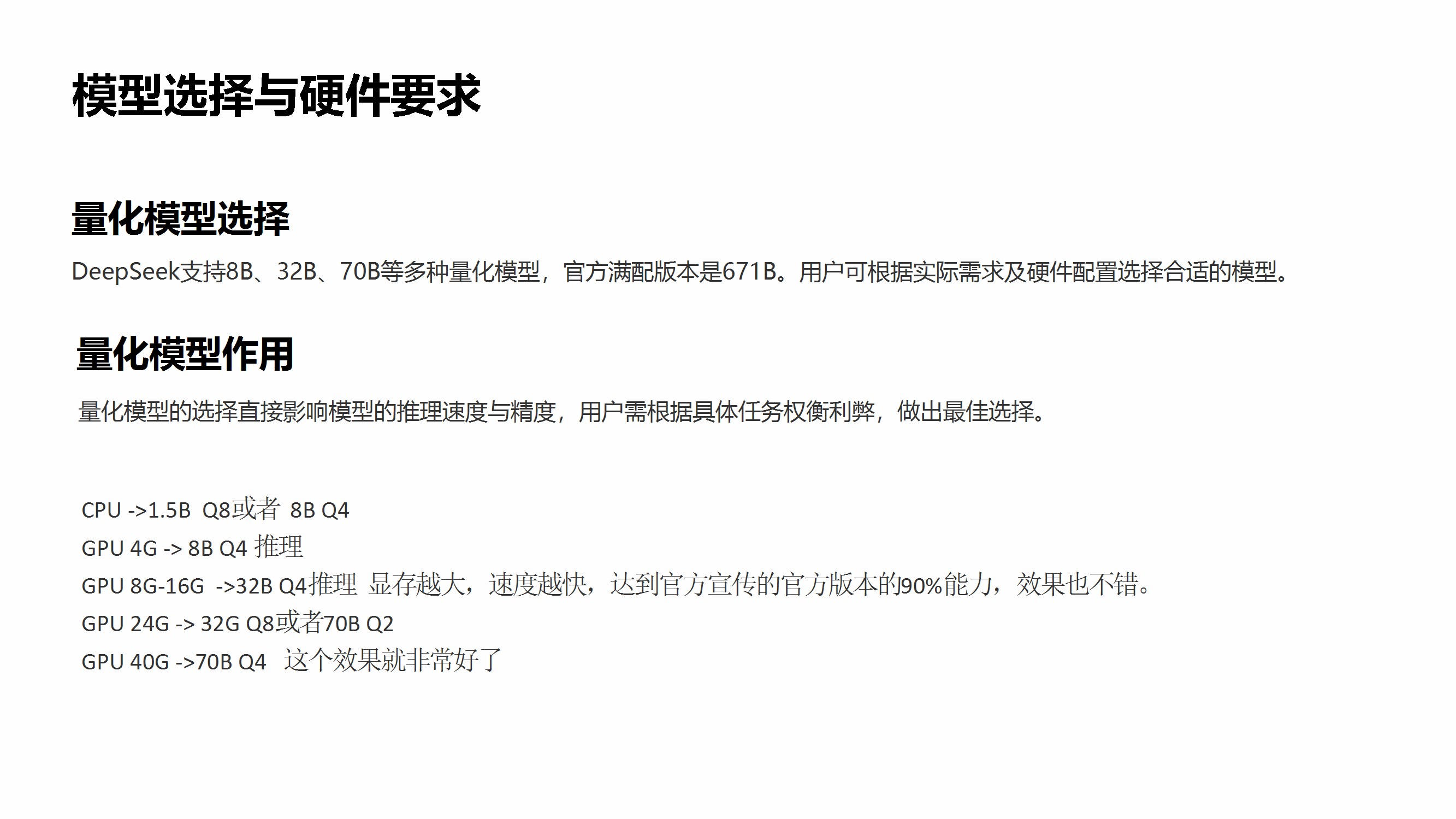

- 模型简介:DeepSeek R1 推理模型具备多轮对话能力,支持本地化部署以保护隐私,提供多种量化模型(如8B、32B、70B),兼容开源生态。

- 应用场景:科研数据分析、自动化工作流优化、日常答疑与信息处理(如写作、周报生成)。

- 使用途径:通过官网/APP、第三方平台(如Cursor、Grok)或本地部署/API调用。

- DeepSeek本地部署

- 必要性:保障数据隐私、支持离线使用、性能优化(充分利用本地硬件资源)。

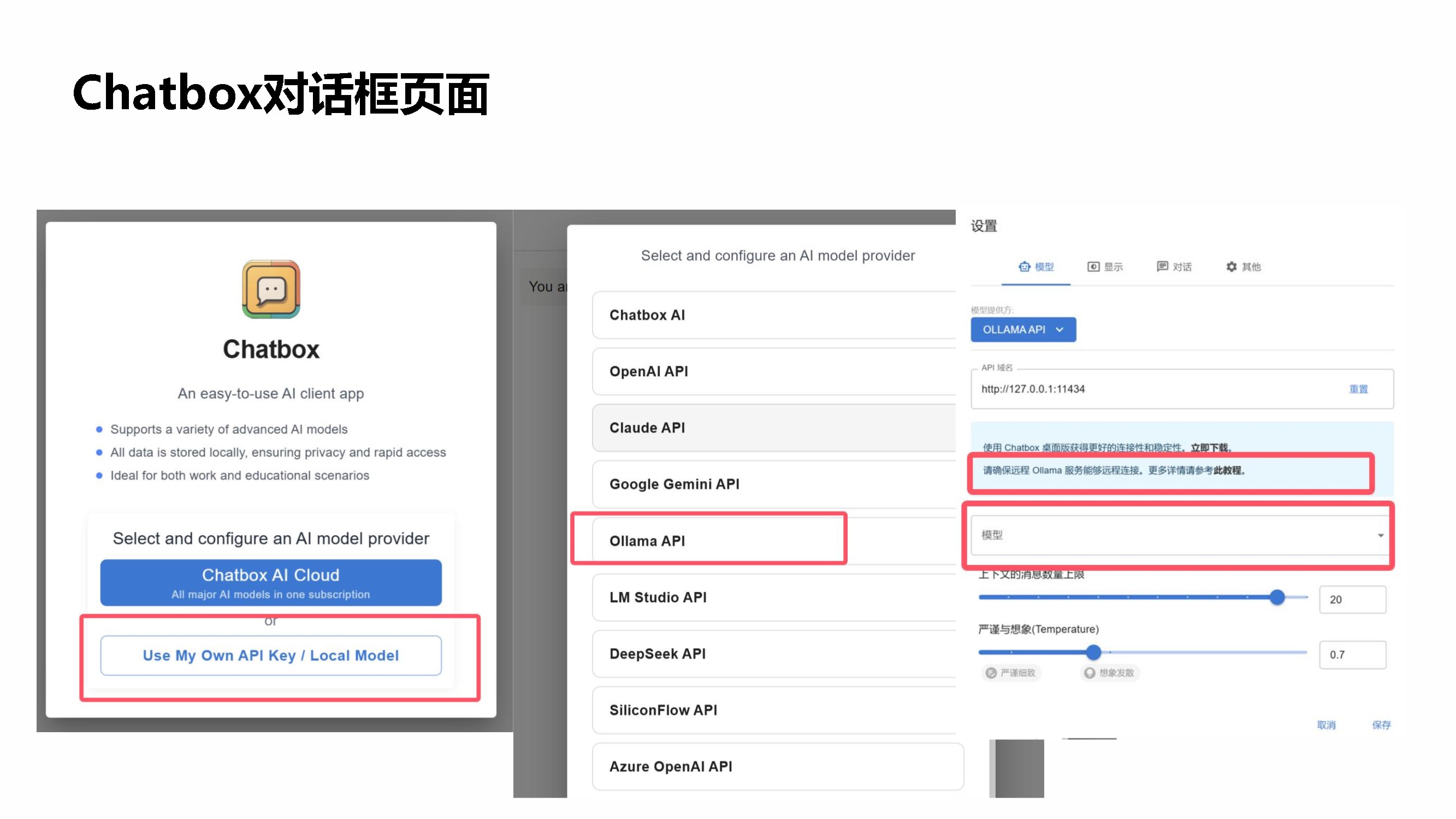

- 部署要求:支持多操作系统(Windows/Linux/macOS),需根据硬件配置选择量化模型(如GPU 8G适用32B Q4模型),提供Ollama和GPT4All两种安装方式。

- 大模型部署:671B版本需高内存+显存(如200GB以上),需通过HuggingFace下载模型文件,使用Ollama配置Modelfile并运行。

- 断网设置:通过虚拟机断网或防火墙规则阻止出站流量,确保本地运行安全。

- 本地知识库搭建

- 工具与流程:基于AnythingLLM搭建本地知识库,需下载嵌入模型(如nomic-embed-text),配置工作区并选择本地LLM(如DeepSeek-R1)。

- 功能扩展:支持文档上传(本地文件、GitHub仓库、Confluence等)、API集成,可实现知识检索、问答及自动化任务。

- 实际应用场景

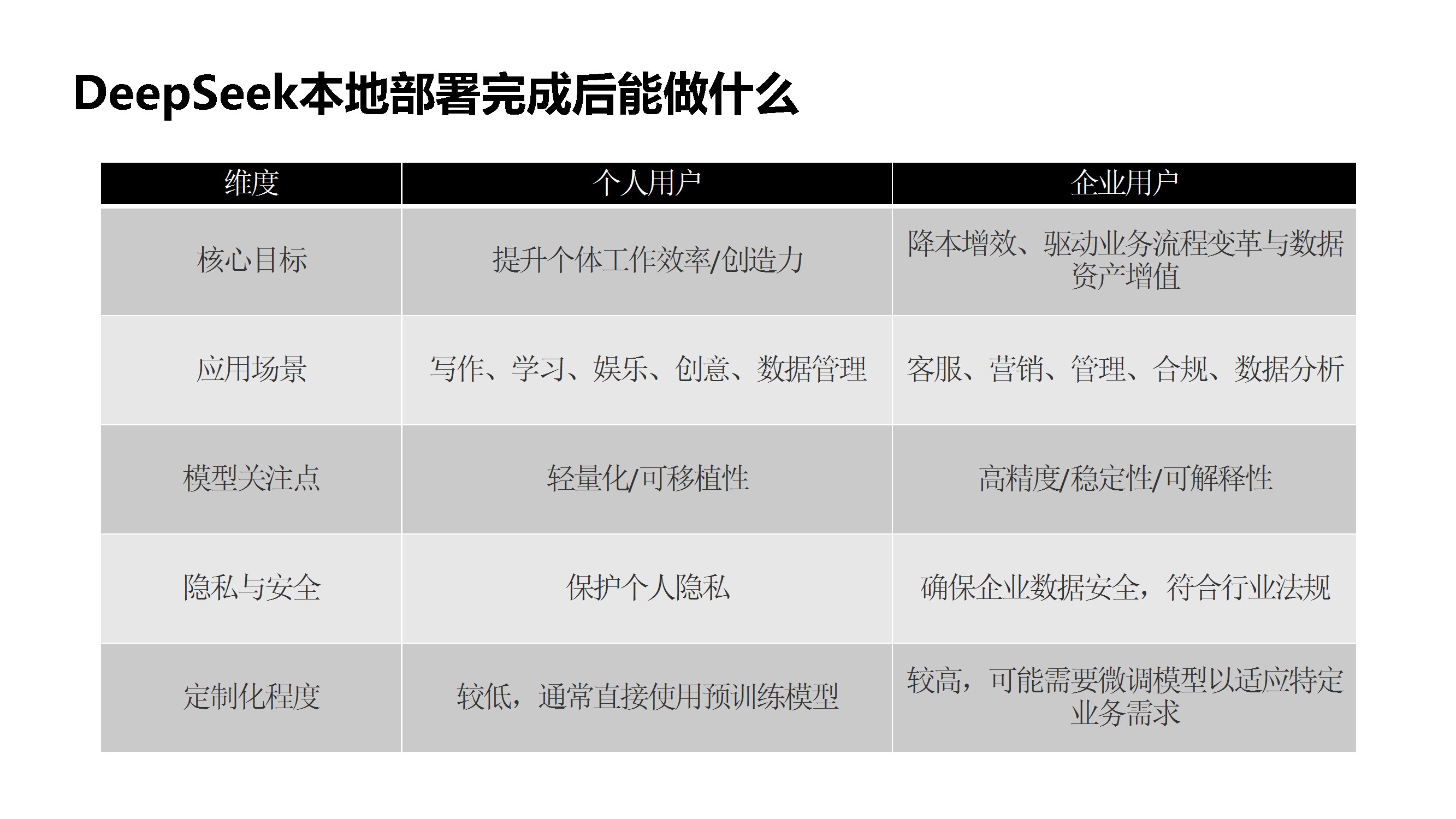

- 个人用户:提升效率(如本地资料管理、私人助理)、技术实验(模型微调、智能家居集成)、隐私保护(处理敏感信息、离线操作)。

- 企业用户:数据安全(敏感数据处理)、知识管理(企业文档自动化、员工培训)、业务流程优化(合同审核、风控监测)。

- 生态产品:元娲虚拟人平台(支持3D/2D虚拟人定制)、元镜视频创作系统(AI生成分镜与成片)、元知AI综述平台(自动化文献分析)。

精彩展示

好了,篇幅的原因我也就不一一列举了,步骤非常的详细,按照步骤亲测本地搭建有效,感兴趣的朋友可以戳下发的地址自取。

PDF无套路下载地址:夸克网盘分享

)