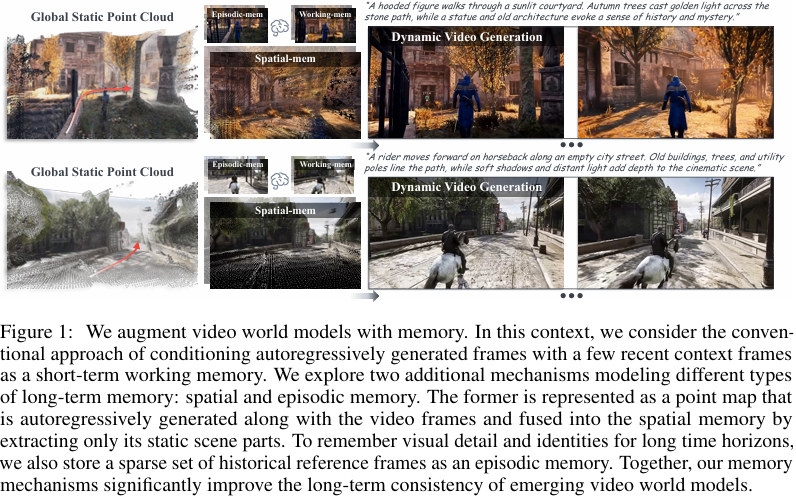

摘要:新兴世界模型根据动作(如相机移动和文本提示等控制信号)自回归地生成视频帧。 由于时间上下文窗口大小有限,这些模型在重访期间往往难以保持场景的一致性,从而导致对先前生成的环境的严重遗忘。 受人类记忆机制的启发,我们引入了一个新的框架,通过基于几何学的长期空间记忆来增强视频世界模型的长期一致性。 我们的框架包括从长期空间记忆中存储和检索信息的机制,我们策划了自定义数据集,以训练和评估具有显式存储的3D记忆机制的世界模型。 我们的评估显示,与相关基线相比,质量、一致性和上下文长度都有所提高,为长期一致的世界生成铺平了道路。Huggingface链接:Paper page,论文链接:2506.05284

一、研究背景和目的

研究背景:

随着人工智能技术的飞速发展,视频生成与模拟技术在多个领域展现出巨大的应用潜力,如游戏开发、虚拟现实、电影制作以及机器人导航等。然而,现有的视频生成模型,尤其是基于自回归扩散模型的方法,在处理长序列视频时面临显著挑战。这些模型通常依赖于有限的时间上下文窗口,导致在重访先前生成的场景时难以保持一致性,进而产生严重的环境遗忘问题。这种局限性限制了视频生成模型在需要长期记忆和场景一致性的应用中的表现。人类记忆系统具有出色的长期记忆能力,能够有效地存储和检索空间信息,从而支持我们在复杂环境中进行导航和交互。受此启发,研究者开始探索如何将类似人类的记忆机制引入视频生成模型中,以提高其长期一致性和场景理解能力。

研究目的:

本文旨在提出一种新的框架,通过引入基于几何的长期空间记忆机制,增强视频世界模型的长期一致性。具体而言,研究目的包括:

- 构建长期空间记忆:设计一种机制,能够存储视频生成过程中产生的静态空间信息,并在需要时检索这些信息以指导后续帧的生成。

- 提高场景一致性:通过利用长期空间记忆,确保在重访先前场景时能够保持高度的一致性,减少环境遗忘问题。

- 评估模型性能:通过定量和定性评估,验证所提框架在提高视频质量、一致性和上下文长度方面的有效性。

- 探索应用潜力:展示所提模型在游戏开发、虚拟现实等领域的潜在应用价值。

二、研究方法

1. 模型架构设计:

本文基于CogVideoX架构进行改进,引入了长期空间记忆机制。模型主要包括以下几个关键组件:

- 视觉编码器:使用3D变分自编码器(VAE)对输入视频进行编码,提取潜在表示。

- 扩散模型:在潜在空间中训练扩散模型,以生成新的视频帧。

- 长期空间记忆:通过截断符号距离函数(TSDF)融合技术,从新生成的帧中预测并过滤静态点图,构建全局静态点云作为长期空间记忆。

- 记忆检索机制:在生成新帧时,从长期空间记忆中检索相关信息,作为条件信号指导视频生成。

2. 记忆存储与检索:

- 静态点云构建:通过TSDF融合技术,将新观察到的静态结构增量式地更新到全局静态点云中。这一过程有效地分离了静态元素(如建筑物)和动态元素(如角色和动物)。

- 记忆检索:在生成新帧时,根据当前相机轨迹渲染静态点云,并通过3DV AE编码为条件潜在表示。这些条件潜在表示与动态上下文信息(如最近几帧)结合,共同指导视频生成。

3. 数据集构建:

为了训练和评估所提模型,本文构建了一个自定义数据集。

数据集从MiraData中收集原始视频,并将其分割为多个97帧的片段。

对于每个片段,前49帧作为源序列,后48帧作为目标序列。在构建数据集时,利用MegaSaM工具提取相机姿态和动态点图,并通过TSDF融合技术生成静态点云作为目标序列的几何指导。

4. 训练与评估:

- 训练过程:模型在8个NVIDIA-A100 GPU上训练6000次迭代,学习率为2×10^-5,批量大小为8。^[16]^在推理阶段,采用最近的5帧历史帧作为上下文,以实现平滑的运动预测。^[17]^

- 评估指标:评估主要关注视图召回一致性(通过PSNR、SSIM和LPIPS等指标衡量)和一般视频质量(通过Vbench中的六个维度进行评估)。此外,还进行了用户研究以进一步验证模型性能。

三、研究结果

1. 定量评估结果:

- 视图召回一致性:在视图召回一致性评估中,所提模型在PSNR、SSIM和LPIPS等指标上均显著优于基线方法。这表明所提模型在重访先前场景时能够保持更高的一致性。

- 一般视频质量:在一般视频质量评估中,所提模型在审美质量、时间闪烁、运动平滑度和主体一致性等方面均表现出色。尽管Wan2.1在成像质量和背景一致性方面略胜一筹,但其往往无法遵循几何指导,导致场景相对静态。

2. 定性评估结果:

- 相机轨迹跟随:所提模型能够更准确地跟随相机轨迹,生成的视频帧与几何指导高度一致。相比之下,基线方法往往无法准确生成显著的相机姿态变化,同时在重访先前场景时容易忘记细节。

- 动作预测:所提模型在生成新动作时表现出色,能够和谐地集成静态和动态元素,并紧密遵循指令。相比之下,基线方法往往无法紧密遵循指令或遭受动作漂移、严重变形甚至角色消失等问题。

3. 用户研究结果:

用户研究结果表明,所提模型在相机准确性、静态一致性和动态合理性等方面均显著优于基线方法。这进一步验证了所提模型在提高视频生成一致性和质量方面的有效性。

4. 消融研究结果:

消融研究表明,长期空间记忆、短期工作记忆和长期 episodic 记忆均对模型性能有显著贡献。去除任何一种记忆机制都会导致模型性能下降。这表明所提框架中的多种记忆机制是相辅相成的,共同提高了模型的长期一致性和场景理解能力。

四、研究局限

尽管所提模型在提高视频生成一致性和质量方面取得了显著进展,但仍存在一些局限性:

1. 记忆容量限制:

长期空间记忆的容量是有限的,随着视频序列的增长,记忆中的信息可能会变得过于庞大而难以有效管理。这可能导致在处理极长视频序列时性能下降。

2. 动态场景处理:

尽管所提模型在处理静态场景时表现出色,但在处理复杂动态场景时仍面临挑战。动态元素的变化可能导致记忆中的静态结构信息失效,从而影响视频生成的一致性。

3. 计算效率:

所提模型在训练和推理过程中需要较高的计算资源,尤其是在处理高分辨率视频时。这可能限制了模型在资源受限环境中的应用潜力。

4. 数据集多样性:

尽管所构建的数据集涵盖了多种场景和相机轨迹,但仍可能存在数据偏差和局限性。未来需要进一步扩展数据集的多样性和覆盖范围,以提高模型的泛化能力。

五、未来研究方向

针对所提模型的局限性和潜在发展方向,未来研究可以关注以下几个方面:

1. 优化记忆管理机制:

研究更高效的记忆管理机制,以应对长期视频序列中的信息爆炸问题。例如,可以探索记忆压缩、选择性遗忘或分层记忆结构等方法,以提高记忆的利用效率和模型的性能。

2. 增强动态场景处理能力:

开发更先进的动态场景处理技术,以应对复杂动态场景中的挑战。例如,可以结合光流估计、物体跟踪或3D重建等技术,以更准确地捕捉和预测动态元素的变化。

3. 提高计算效率:

探索更高效的模型架构和训练算法,以降低所提模型的计算成本。例如,可以采用模型压缩、量化或知识蒸馏等技术来减小模型大小并提高推理速度。此外,还可以研究并行计算、分布式训练或硬件加速等方法,以充分利用计算资源并提高训练效率。

4. 扩展数据集多样性:

继续扩展数据集的多样性和覆盖范围,以提高模型的泛化能力。可以收集更多不同类型的视频数据,包括不同场景、相机轨迹和动态元素的变化。此外,还可以考虑引入对抗性样本生成技术来提高模型的鲁棒性。

5. 探索跨领域应用:

研究所提模型在其他领域的应用潜力,如游戏开发、虚拟现实、电影制作和机器人导航等。通过跨领域合作和知识共享,推动所提模型技术的进一步发展和应用。

6. 结合多模态信息:

探索将多模态信息(如声音、触觉等)融入视频生成模型中的方法。

多模态信息的融合可以为模型提供更全面的环境感知和更准确的决策依据,从而提高视频生成的一致性和质量。例如,可以结合音频信号来指导视频中的声音效果生成,或结合触觉反馈来增强虚拟现实体验的真实感。

7. 实时性能优化:

针对实时应用场景,研究如何优化所提模型的实时性能。通过改进算法、优化硬件配置或采用分布式计算等技术手段,确保所提模型能够在实时环境中稳定运行并满足任务需求。这对于游戏开发、虚拟现实和机器人导航等领域尤为重要。