概念理解

通过将一个复杂且大型的教师模型中的知识传递给一个较小的学生模型,从而在保持模型性能的前提下,减少模型的计算复杂度和内存占用。知识蒸馏的概念最早由Geoffrey Hinton及其同事在2015年提出,并在他们的论文《Distilling the Knowledge in a Neural Network》中被详细阐述。Hinton的这篇开山之作为知识蒸馏奠定了理论基础,并在深度学习领域引起了广泛关注和应用。

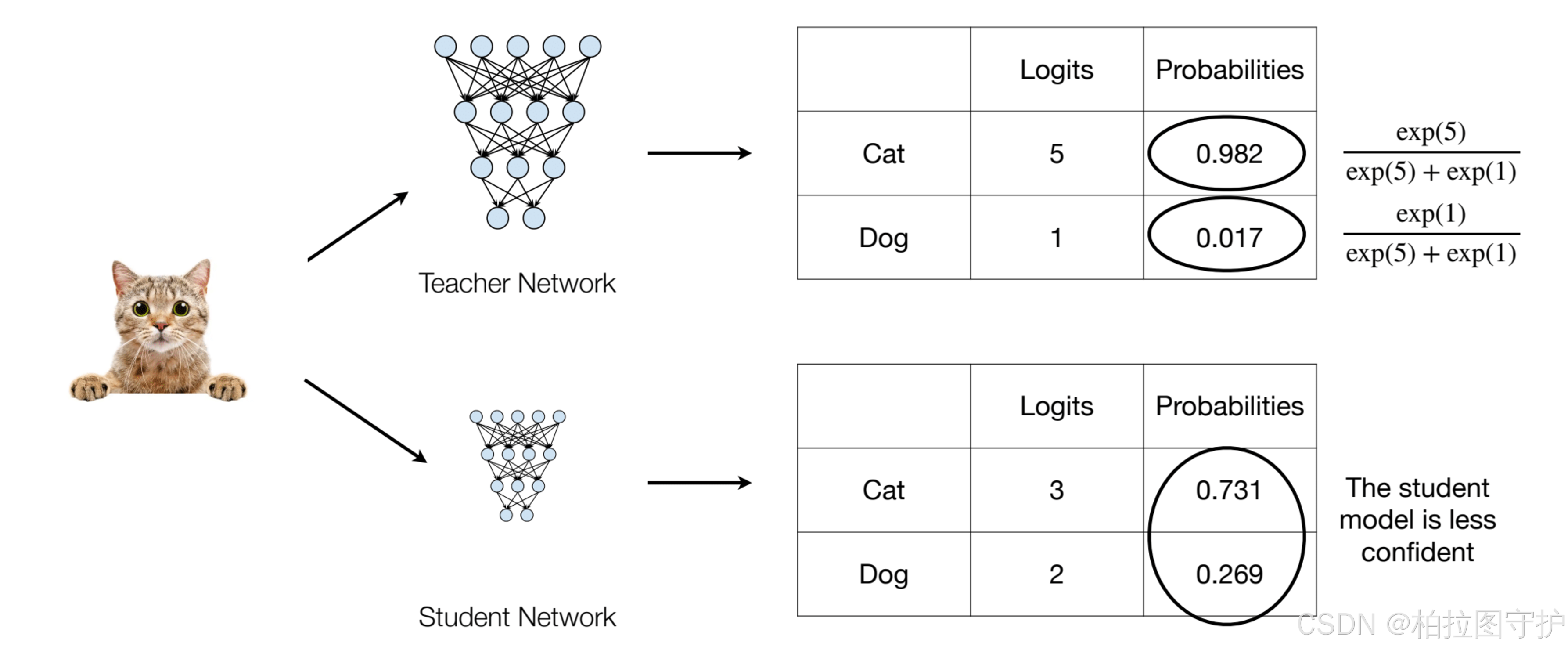

在这篇论文中,Hinton提出了软标签。大多数传统的神经网络训练都是基于“硬目标”,也就是标签数据的类别,例如一个图像是“猫”还是“狗”。但Hinton认为输出的概率分布比硬标签蕴含更多的知识。例如,如果教师模型对图像的预测是“90%是猫,10%是狗”,这个信息要比直接给出“猫”这个标签更有价值,因为它表明模型认为“狗”也是有可能的,只是可能性较低。这些信息能够帮助学生模型学到更丰富的表示,而不仅仅是正确答案。

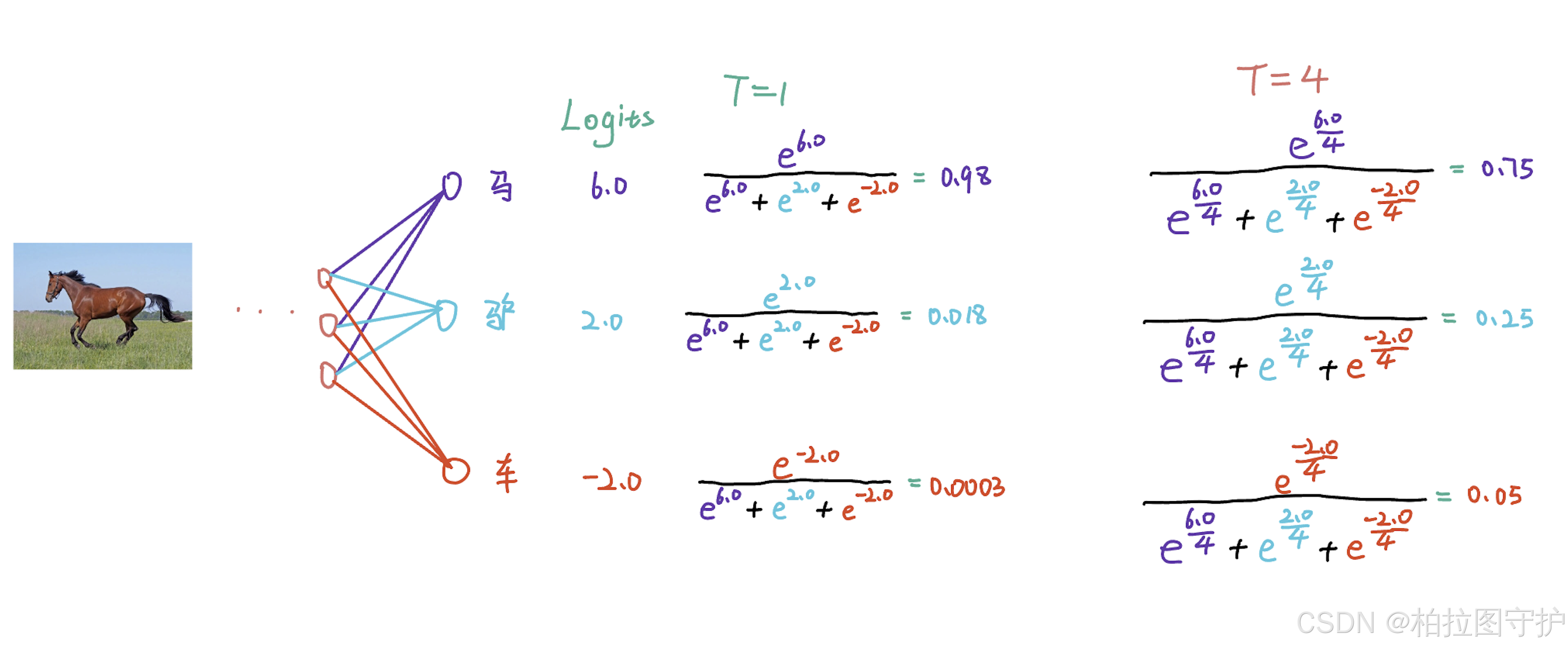

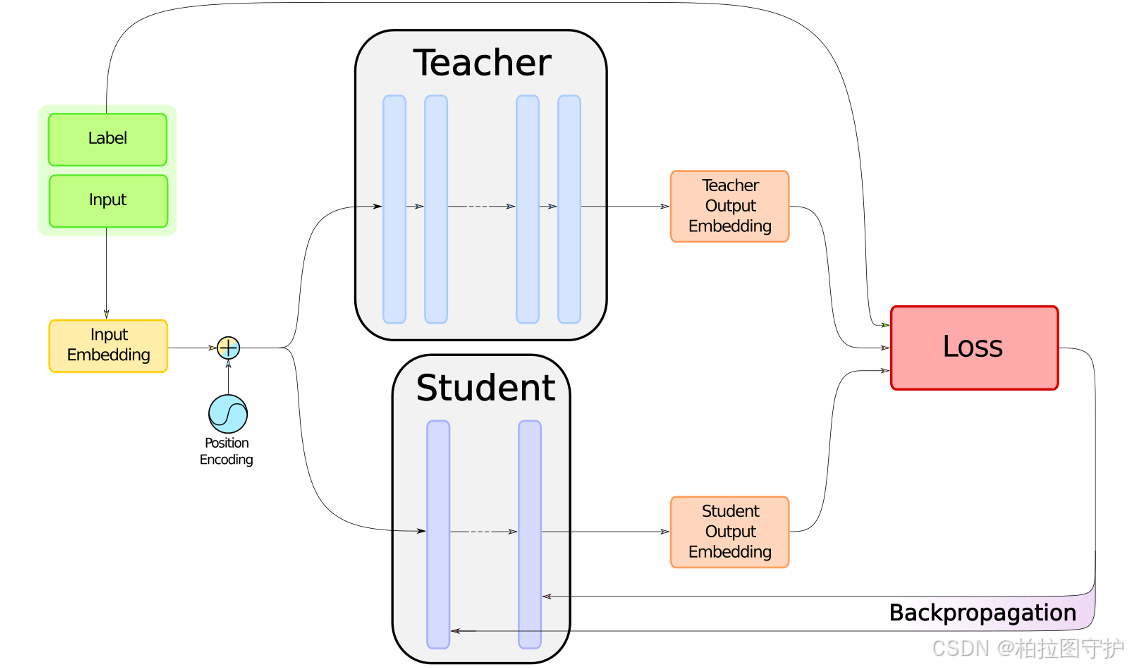

蒸馏损失函数是论文的核心之一。学生模型在训练过程中,不仅使用标准的交叉熵损失来学习训练集的硬标签,还使用教师模型的软目标来优化损失函数。具体来说,Hinton引入了一个温度参数T来软化教师模型的输出,这样可以让概率分布中的每一个类别都变得更加接近,从而让学生模型更好地学习类别之间的相对关系。当温度T较高时,输出的概率分布更加平滑,更多信息被传递给学生模型。

蒸馏损失函数是论文的核心之一。学生模型在训练过程中,不仅使用标准的交叉熵损失来学习训练集的硬标签,还使用教师模型的软目标来优化损失函数。具体来说,Hinton引入了一个温度参数T来软化教师模型的输出,这样可以让概率分布中的每一个类别都变得更加接近,从而让学生模型更好地学习类别之间的相对关系。当温度T较高时,输出的概率分布更加平滑,更多信息被传递给学生模型。

损失函数的组成包括两个部分:一部分是使用标准硬标签的交叉熵损失,另一部分是基于教师模型软目标的交叉熵损失。整个训练过程是通过优化这两部分损失的加权和来完成的。教师模型的输出作为“暗示”信息帮助学生模型捕捉更细致的知识。

Hinton的知识蒸馏方法在这篇论文中展示了非常显著的效果。通过将一个复杂的深度网络(例如大型卷积神经网络或多个模型集成体)作为教师模型,再将其知识传递给一个小型的学生模型,学生模型的性能通常可以接近甚至达到教师模型的水平,但训练和推理的计算开销大大降低。这使得知识蒸馏特别适合资源有限的场景,如嵌入式设备、移动设备、实时推理等应用。

实际应用

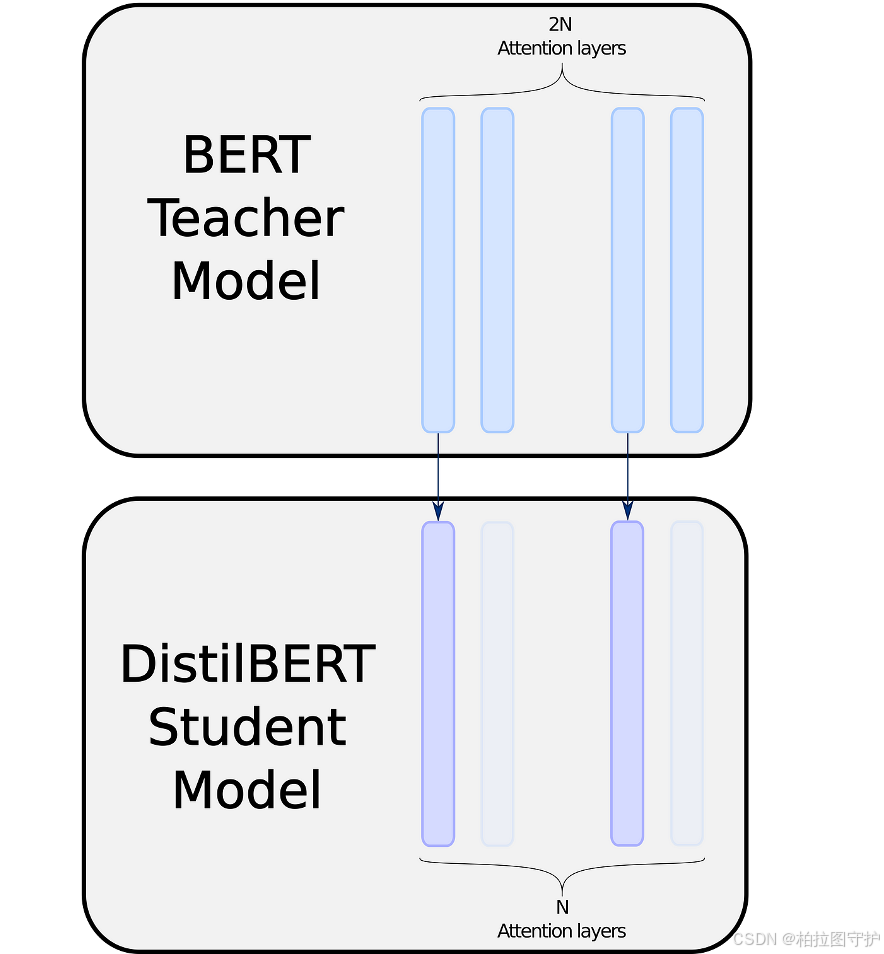

DistilBERT 是通过对 BERT 使用知识蒸馏方法得到的。在训练 DistilBERT 的过程中,一个预训练好的 BERT 模型作为教师模型,而 DistilBERT 作为学生模型,学生模型通过学习教师模型的知识来获得类似的语言理解能力。

DistilBERT 相比原始 BERT 采用了更精简的架构,它将 BERT 的 Transformer 层从 12 层减少到 6 层,使得模型的复杂度减少了一半。虽然 Transformer 层减少了,但通过知识蒸馏的方式,DistilBERT 保留了大部分的语言理解能力,其性能通常达到原始 BERT 的 97% 左右,而推理速度却提升了近 60%。

参考文献

- https://www.datawhale.cn/learn/content/68/965

- https://www.dropbox.com/scl/fi/jh071zqee27yr7bkiy3ll/lec09.pdf?rlkey=50yvvxrcnpsg7krci2o91kbc1&e=1&dl=0

- Hinton, G., Vinyals, O., & Dean, J. (2015). Distilling the Knowledge in a Neural Network. arXiv preprint arXiv:1503.02531.