在深度学习领域,循环神经网络(RNN)及其改进版本长短期记忆网络(LSTM)凭借处理序列数据的卓越能力,成为自然语言处理、语音识别等诸多领域的 “得力干将”。

然而,对于初学者而言,RNN 和 LSTM 的架构设计,尤其是输出机制部分,存在不少理解误区。

例如,

“RNN 模型不是本身就可以输出预测词么?为什么还要全连接层和 Logsoftmax 层?”

“LSTM 输出门有 sigmoid 函数,能直接输出预测词概率吗?”

本文将结合具体示例,深入剖析这些问题,助力大家扫清理解障碍。

一、RNN 架构剖析:全连接层与 LogSoftmax 层的不可或缺性

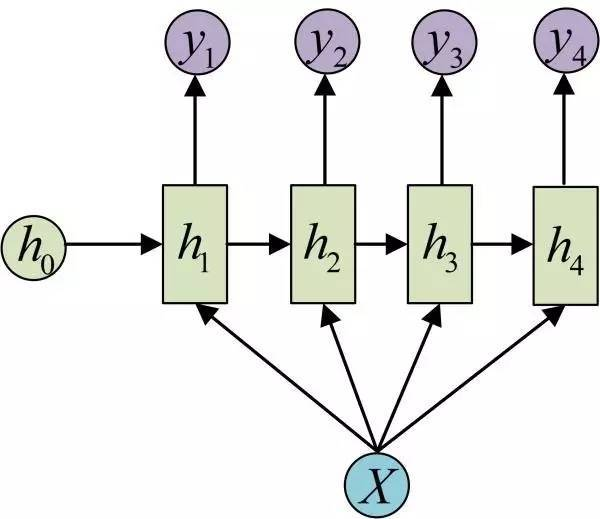

RNN 的核心功能与局限性

RNN 的核心在于通过隐藏状态维持序列的历史信息,在每个时间步基于当前输入和上一时间步隐藏状态计算输出。但 RNN 的直接输出(隐藏状态)存在明显局限:

其一,隐藏状态维度由hidden_size参数决定,与输出类别数往往不匹配;

其二,隐藏状态是实数,并非概率分布;其三,它自身缺乏将特征映射到具体类别的能力。

全连接层:特征到类别的桥梁

全连接层(nn.Linear)在 RNN 架构中扮演着关键角色。它能够将 RNN 输出的隐藏状态(维度为hidden_size)映射到输出类别空间(维度为output_size),通过线性变换将 RNN 提取的抽象特征转换为与具体分类任务相关的特征表示,同时引入额外参数增强模型表达能力。

从数学角度看,全连接层执行的操作是

output = W * hidden_state + b,

W是权重矩阵,b是偏置向量,hidden_state是 RNN 的输出 。

LogSoftmax 层:生成概率分布

LogSoftmax 层的作用是将全连接层的输出转换为概率分布,计算每个类别的对数概率,同时提升数值稳定性。

数学上,LogSoftmax 执行的操作是log_prob_i = log(exp(x_i) / sum(exp(x_j))),其中x_i是全连接层的第i个输出。这一层对于后续使用交叉熵损失函数进行模型训练至关重要,因为交叉熵损失函数需要模型输出概率分布。

示例:基础 RNN 模型实现

以一个简单的 RNN 类实现为例:

class RNN(nn.Module):def __init__(self, input_size, hidden_size, output_size, num_layers=1):super(RNN, self).__init__()self.input_size = input_sizeself.hidden_size = hidden_sizeself.output_size = output_sizeself.num_layers = num_layersself.rnn = nn.RNN(self.input_size, self.hidden_size, self.num_layers)self.linear = nn.Linear(self.hidden_size, self.output_size)self.softmax = nn.LogSoftmax(dim=-1)def forward(self, input, hidden):input = input.unsqueeze(1)rr, hn = self.rnn(input, hidden)tmprr = rr[-1]tmprr = self.linear(tmprr)return self.softmax(tmprr), hndef inithidden(self):return torch.zeros(self.num_layers, 1, self.hidden_size)

在这个示例中,输入数据先经过 RNN 层提取序列特征,再通过全连接层将特征映射到输出维度,最后由 LogSoftmax 层生成概率分布,清晰展现了三者协同工作完成分类任务的过程。

二、LSTM 架构:输出门与预测概率的区别

LSTM 的输出门机制

LSTM 通过输入门、遗忘门和输出门等门控机制解决了传统 RNN 的梯度消失问题。输出门使用 sigmoid 函数,其计算公式为

o_t = σ(W_o * [h_{t-1}, x_t] + b_o),

h_t = o_t * tanh(C_t) ,

σ是 sigmoid 函数,h_t是当前时间步的隐藏状态,C_t是当前时间步的细胞状态。

输出门的主要作用是控制细胞状态的哪些部分会被输出到隐藏状态,对细胞状态进行选择性输出,保留重要信息。

LSTM 输出门≠预测概率

尽管 LSTM 的输出门使用了 sigmoid 函数,但它并不能直接输出预测词概率。原因主要有三点:

其一,维度不匹配,LSTM 隐藏状态的维度由hidden_size决定,通常不等于词汇表大小;

其二,概率分布要求不满足,预测词概率需要对整个词汇表的概率分布,且所有词的概率之和为 1,而 LSTM 的输出门只控制隐藏状态的每个维度的输出强度,不产生概率分布;

其三,激活函数不匹配,sigmoid 函数将每个维度独立映射到[0,1],但不保证所有维度之和为 1,而 softmax 函数对所有维度进行归一化,确保所有输出之和为 1 。

示例:LSTM 情感分析模型

以电影评论情感分析为例,构建一个 LSTM 模型:

class LSTMSentimentAnalysis(nn.Module):def __init__(self, vocab_size, embedding_dim, hidden_dim, output_dim, dropout=0.5):super().__init__()self.embedding = nn.Embedding(vocab_size, embedding_dim)self.lstm = nn.LSTM(embedding_dim, hidden_dim, batch_first=True)self.fc = nn.Linear(hidden_dim, output_dim)self.dropout = nn.Dropout(dropout)self.softmax = nn.Softmax(dim=1)def forward(self, text):embedded = self.embedding(text)lstm_out, (hidden, cell) = self.lstm(embedded)hidden = hidden.squeeze(0)hidden = self.dropout(hidden)fc_out = self.fc(hidden)probabilities = self.softmax(fc_out)return probabilities

在这个模型中,输入的电影评论数据先经过词嵌入层转换为向量表示,再进入 LSTM 层处理,之后通过全连接层将 LSTM 的隐藏状态映射到输出维度,最后由 Softmax 层生成情感分类的概率分布,直观体现了 LSTM 模型完整的输出流程。

三、总结

RNN 和 LSTM 本身强大的序列处理能力,并不意味着它们的输出可以直接作为预测结果。全连接层和 Softmax(或 LogSoftmax)层在模型架构中不可或缺,它们分别承担着特征映射和概率生成的重要职责,共同确保模型能够准确完成分类任务。

LSTM 的输出门虽然使用了 sigmoid 函数,但与预测概率的生成有着本质区别。希望通过本文的示例与原理剖析,能帮助新学习 RNN 和 LSTM 的同学走出理解误区,更好地掌握这两种经典神经网络架构的设计逻辑与应用方法。

)

感知机)