解密企业级大模型智能体Agentic AI 关键技术:MCP、A2A、Reasoning LLMs-docker MCP解析

这里面有很重要的原因其中一个很其中一个原因是因为如果你使用docker的方式,你可以在虚拟环境下就类似于这个沙箱的这个机制可以进行隔离。这对于安全,但另外一方面对资源的更有效的利润带来非常大的价值。还有一点就是大家可以看一下这个cloud flare MCP。大家可以看啊,这也是在你做企业级的这个产品的部署或者运维的时候,非常重要的一个平台。关于这个cloud的flare 本身我就不说太多了。因为大家如果作为一个开发者,肯定是多少都会有所接触的那我们使用MCP的时候,可以借助这样的一个平台,来完成他的隔离和资源的最有效的应用。大家可以看在这边他谈到all of,然后这边MCP agent remote等等之类的,但这里面其实我们可以稍微看一下。

就是从这个cloud的flare的角度来讲,它会基于他已有的云平台给我们提供隔离。其实当然它也提供了一系列的功能支持。如果你从用户的角度, 用户要使用我们的AI应用程序到AI应用程序要使用MCP的功能。它会有MCP的这个客户端 。这客户端会通过MCP协议,就是model context protos和我们的MCP server进行沟通。

我们MCP server它作为相当一个沙箱或者隔离的环境,是在我们cloud flare上运行的,那在这里面,cloud flare给我们会提供很多,例如说这个安全认证等之类的一些功能。它也会提供一些定制化或者是增强的的一些功能。大家可以看这边会有 workflow,然后这边有 browser之类的,那我们的MCP server整个的这个API points或者说third party API and services进行沟通,所以我们在这里分享docker对MCP的支持,以及我们说的云平台对MCP的支持。我相信大家应该也会立即想到另外一个对MCP支持非常非常强有力的平台,大家应该知道是什么 ?是 GCP.

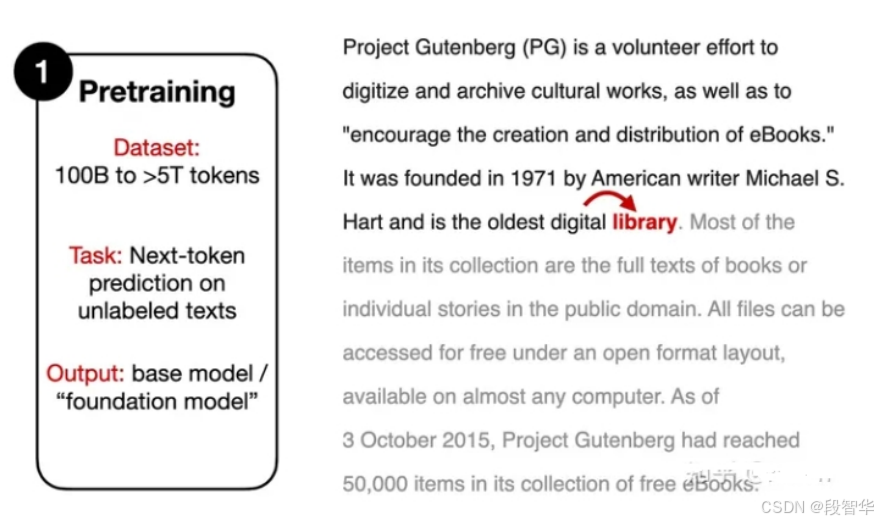

具体介绍一下 预训练(Pre-training)?

预训练(Pre-training):利用数十亿到数万亿个token的庞大文本语料库 对模型继续 预训练,使 模型能够 根据提供的文本来预测「下一个单词」